Zainspirowana zdolnością ludzi do radzenia sobie z nieznanymi obiektami, grupa z Laboratorium Informatyki i Sztucznej Inteligencji MIT (CSAIL) zaprojektowała Feature Fields for Robotic Manipulation (F3RM), system, który łączy obrazy 2D z cechami modelu fundamentowego w sceny 3D, aby pomóc robotom zidentyfikować i chwycić pobliskie przedmioty. F3RM może interpretować otwarte podpowiedzi językowe od ludzi, dzięki czemu metoda ta jest pomocna w rzeczywistych środowiskach, które zawierają tysiące obiektów, takich jak magazyny i gospodarstwa domowe.

W SKRÓCIE

Feature Fields for Robotic Manipulation (F3RM) łączy obrazy 2D i cechy modeli w sceny 3D, umożliwiając robotom chwytanie obiektów w oparciu o otwarte opisy ludzkie, zwiększając możliwości adaptacyjne.

Łącząc percepcję przestrzenną i rozumienie semantyczne, F3RM umożliwia robotom skuteczną interpretację niejasnych poleceń, takich jak wybór “wysokiego kubka”.

F3RM oferuje robotom możliwość interpretowania otwartych poleceń tekstowych przy użyciu języka naturalnego, pomagając maszynom manipulować obiektami. W rezultacie maszyny mogą zrozumieć mniej konkretne żądania od ludzi i nadal wykonać żądane zadanie. Na przykład, jeśli użytkownik poprosi robota o “podniesienie wysokiego kubka”, robot może zlokalizować i chwycić przedmiot, który najlepiej pasuje do tego opisu.

“Tworzenie robotów, które mogą generalizować w prawdziwym świecie, jest niezwykle trudne” – powiedział Ge Yang, postdoc w National Science Foundation AI Institute for Artificial Intelligence and Fundamental Interactions i MIT CSAIL. “Naprawdę chcemy dowiedzieć się, jak to zrobić, więc w tym projekcie staramy się naciskać na agresywny poziom uogólnienia, od zaledwie trzech lub czterech obiektów do wszystkiego, co znajdziemy w MIT’s Stata Center. Chcieliśmy dowiedzieć się, jak sprawić, by roboty były tak elastyczne jak my sami, ponieważ możemy chwytać i umieszczać obiekty, nawet jeśli nigdy wcześniej ich nie widzieliśmy”.

Uczenie się “co jest gdzie przez patrzenie”

Metoda ta może pomóc robotom w wybieraniu przedmiotów w dużych centrach realizacji zamówień, w których panuje nieunikniony bałagan i nieprzewidywalność. W takich magazynach roboty często otrzymują opis inwentarza, który muszą zidentyfikować. Roboty muszą dopasować dostarczony tekst do obiektu, niezależnie od różnic w opakowaniu, aby zamówienia klientów były wysyłane prawidłowo.

Przykładowo, centra realizacji zamówień głównych sprzedawców internetowych mogą zawierać miliony przedmiotów, z których wiele robot nigdy wcześniej nie spotkał. Aby działać na taką skalę, roboty muszą rozumieć geometrię i semantykę różnych przedmiotów, a niektóre z nich znajdują się w ciasnych przestrzeniach. Dzięki zaawansowanym zdolnościom percepcji przestrzennej i semantycznej F3RM, robot może stać się bardziej skuteczny w lokalizowaniu obiektu, umieszczaniu go w pojemniku, a następnie wysyłaniu go do pakowania. Ostatecznie pomogłoby to pracownikom fabryk w bardziej wydajnej realizacji zamówień klientów.

“Jedną z rzeczy, która często zaskakuje ludzi w przypadku F3RM, jest to, że ten sam system działa również w skali pomieszczenia i budynku i może być wykorzystywany do tworzenia środowisk symulacyjnych do nauki robotów i dużych map” – powiedział Yang. “Ale zanim zwiększymy skalę tej pracy, chcemy najpierw sprawić, by ten system działał naprawdę szybko. W ten sposób będziemy mogli wykorzystać ten typ reprezentacji do bardziej dynamicznych zadań sterowania robotami, miejmy nadzieję, że w czasie rzeczywistym, tak aby roboty, które obsługują bardziej dynamiczne zadania, mogły używać go do percepcji”.

Zespół MIT zauważa, że zdolność F3RM do rozumienia różnych scen może uczynić go użytecznym w środowiskach miejskich i domowych. Podejście to może na przykład pomóc spersonalizowanym robotom w identyfikacji i podnoszeniu określonych przedmiotów. System pomaga robotom w fizycznym i spostrzegawczym uchwyceniu otoczenia.

“Percepcja wzrokowa została zdefiniowana przez Davida Marra jako problem poznania ‘co jest gdzie poprzez patrzenie'” – powiedział starszy autor Phillip Isola, profesor MIT inżynierii elektrycznej i informatyki oraz główny badacz CSAIL. “Najnowsze modele fundamentów stały się naprawdę dobre w wiedzeniu, na co patrzą; mogą rozpoznawać tysiące kategorii obiektów i dostarczać szczegółowych opisów tekstowych obrazów. Jednocześnie pola promieniowania stały się naprawdę dobre w reprezentowaniu tego, gdzie znajdują się rzeczy w scenie. Połączenie tych dwóch podejść może stworzyć reprezentację tego, co jest gdzie w 3D, a nasza praca pokazuje, że ta kombinacja jest szczególnie przydatna w zadaniach robotycznych, które wymagają manipulowania obiektami w 3D”.

Tworzenie “cyfrowego bliźniaka”

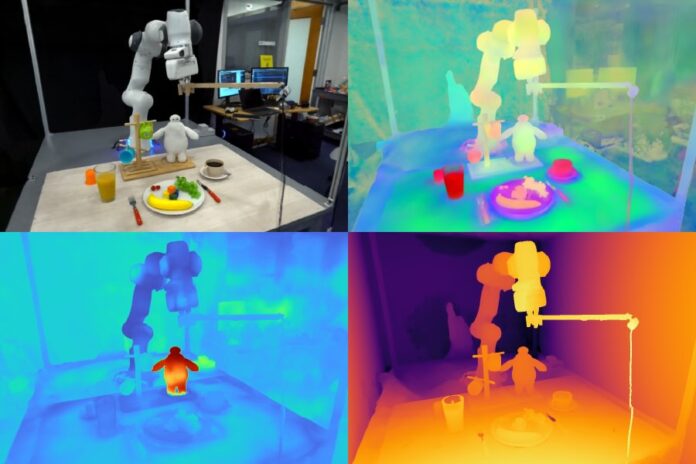

F3RM zaczyna rozumieć swoje otoczenie, robiąc zdjęcia za pomocą kijka do selfie. Zamontowana kamera robi 50 zdjęć w różnych pozach, umożliwiając zbudowanie neuronowego pola promieniowania (NeRF), metody głębokiego uczenia, która wykorzystuje obrazy 2D do zbudowania sceny 3D. Ten kolaż zdjęć RGB tworzy “cyfrowego bliźniaka” otoczenia w postaci 360-stopniowej reprezentacji tego, co znajduje się w pobliżu.

Oprócz bardzo szczegółowego pola promieniowania neuronowego, F3RM buduje również pole cech, aby rozszerzyć geometrię o informacje semantyczne. System wykorzystuje CLIP, model podstawy widzenia wyszkolony na setkach milionów obrazów, aby skutecznie uczyć się pojęć wizualnych. Poprzez rekonstrukcję cech 2D CLIP dla zdjęć wykonanych kijem do selfie, F3RM skutecznie podnosi cechy 2D do reprezentacji 3D.

Zachowanie otwartości

Po otrzymaniu kilku demonstracji robot stosuje to, co wie o geometrii i semantyce, aby chwytać obiekty, z którymi nigdy wcześniej się nie spotkał. Po przesłaniu przez użytkownika zapytania tekstowego robot przeszukuje przestrzeń możliwych chwytów, aby zidentyfikować te, które z największym prawdopodobieństwem odniosą sukces w podniesieniu obiektu żądanego przez użytkownika. Każda potencjalna opcja jest oceniana na podstawie jej znaczenia dla podpowiedzi, podobieństwa do demonstracji, na których robot został przeszkolony, oraz tego, czy powoduje jakiekolwiek kolizje. Najwyżej oceniony chwyt jest następnie wybierany i wykonywany.

Aby zademonstrować zdolność systemu do interpretowania otwartych żądań od ludzi, naukowcy poprosili robota o podniesienie Baymaxa, postaci z filmu Disneya “Big Hero 6”. Podczas gdy F3RM nigdy nie został bezpośrednio przeszkolony do podnoszenia zabawki superbohatera z kreskówki, robot wykorzystał swoją świadomość przestrzenną i funkcje językowo-wizualne z modeli podstawowych, aby zdecydować, który obiekt chwycić i jak go podnieść.

F3RM umożliwia również użytkownikom określenie, który obiekt ma być obsługiwany przez robota na różnych poziomach szczegółowości językowej. Na przykład, jeśli jest metalowy kubek i szklany kubek, użytkownik może poprosić robota o “szklany kubek”. Jeśli bot widzi dwa szklane kubki i jeden z nich jest wypełniony kawą, a drugi sokiem, użytkownik może poprosić o “szklany kubek z kawą”. Funkcje modelu fundamentalnego osadzone w polu funkcji umożliwiają ten poziom otwartego zrozumienia.

“Gdybym pokazał osobie, jak podnieść kubek za wargę, mogłaby z łatwością przenieść tę wiedzę do podnoszenia obiektów o podobnej geometrii, takich jak miski, zlewki pomiarowe, a nawet rolki taśmy. W przypadku robotów osiągnięcie takiego poziomu zdolności adaptacyjnych było sporym wyzwaniem” – powiedział doktorant MIT, współpracownik CSAIL i współautor William Shen. “F3RM łączy zrozumienie geometrii z semantyką modeli fundamentalnych wyszkolonych na danych w skali internetowej, aby umożliwić ten poziom agresywnego uogólniania na podstawie niewielkiej liczby demonstracji”.

Adam Zewe, MIT News Office